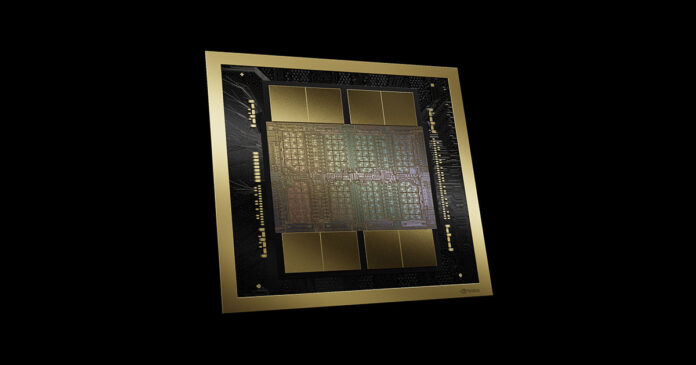

Lanseringen av ChatGPT fick efterfrågan på AI-beräkningskretsar att ta fart rejält och industrin har haft svårt att möta den skyhöga efterfrågan. I centrum för detta står TSMC, som tillverkar alla högpresterande värda namnet och kämpar med att skala upp kapaciteten för att möta efterfrågan från de chipdesigners som förlagt produktion i deras fabriker, såsom Nvidia och AMD.

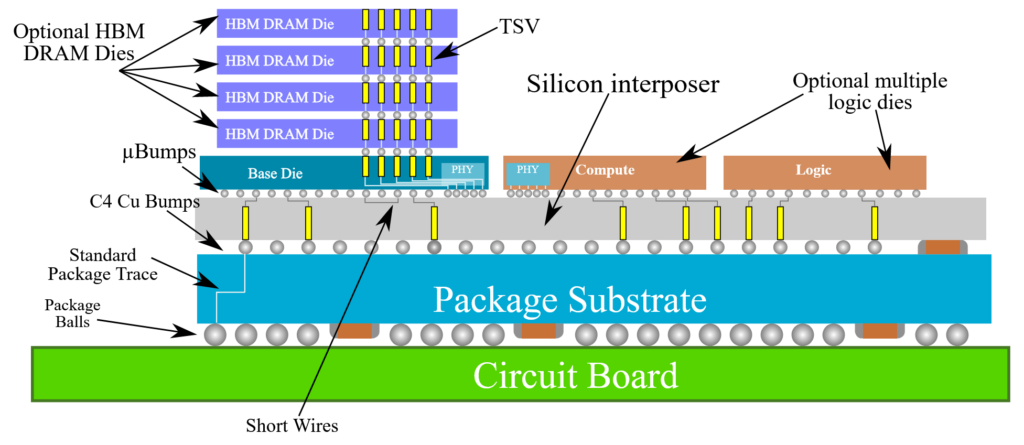

I en ny rapport från investmentbanken Morgan Stanley framgår att TSMC lyckats bättre än väntat med att skala upp produktion av en nyckelkomponent. Det handlar om bolagets Chip-on-Wafer-on-Substrate (CoWoS), en typ av avancerad kretspaketering som krävs för framställandet av de mest högpresterande AI-lösningarna. Medan det rått viss brist på kapacitet för tillverkning av själva beräkningskretsen är det just paketering som är den stora flaskhalsen när världen AI-rustar.

Analytikern Zhan Jiahong på Morgan Stanley estimerar att TSMC kommer att kunna framställa 80 000 kiselskivor per månad (WSPM) under 2025, vilket vore ett helt år tidigare än väntat. Det har tidigare rapporterats om att TSMC under slutet av 2023 hade en kapacitet om 11 000 WSPM och att denna skulle öka rejält till 32 000 WSPM under 2024, för att 2025 nå 45 000 WSPM. Intressant i sammanhanget är att TSMC tidigare angett att det senare skulle räcka för att möta efterfrågan, men av uppgifterna från Morgan Stanley att döma ser den uppskattningen annorlunda ut idag än för ett halvår sedan.

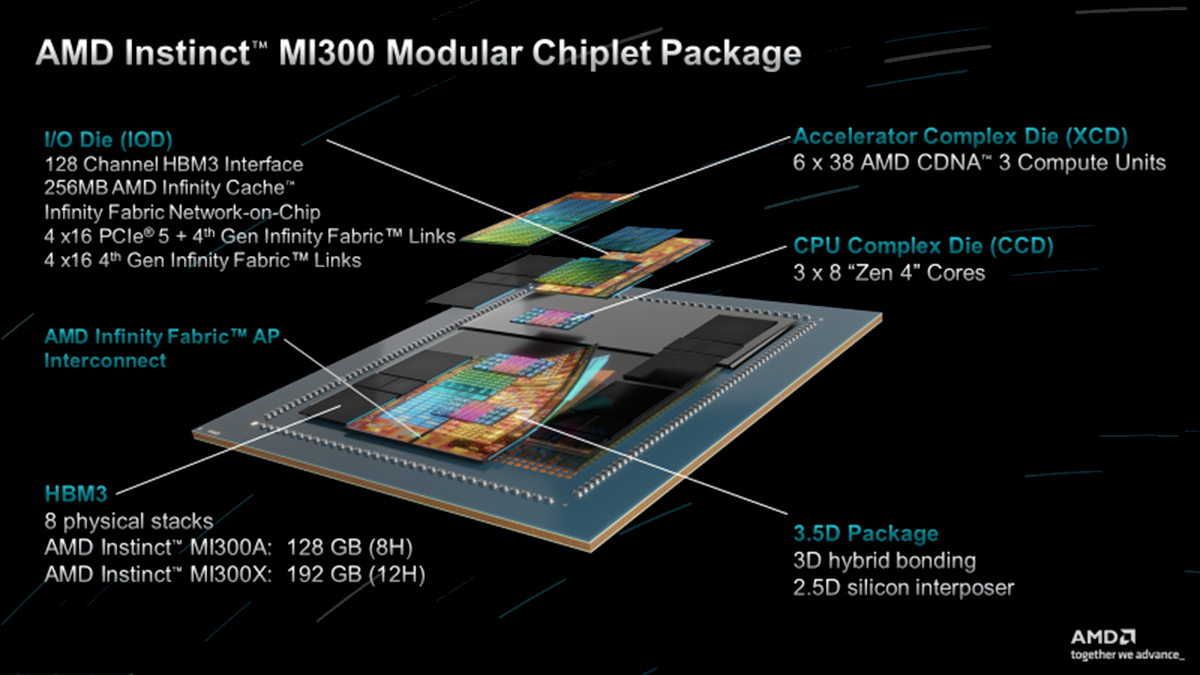

Anledningen till att paketeringstekniken CoWoS är en fundamental del för beräkningskretsar av mest avancerat snitt stavas minnestekniken High-Bandwidth Memory (HBM). Genom att placera dessa minneskapslar nära beräkningskretsen är det möjligt att uppnå en bandbredd om flertalet terabyte per sekund (TB/s), vilket tillsammans med så stor minneskapacitet som möjligt underlättar vid AI-beräkningar där stora mängder data behandlas.

Ovanpå CoWoS-paketeringen placeras i regel fyra till åtta HBM-kapslar runt en eller flera logikkretsar som står för beräkningskraften. Här står AMD idag för ”rekordet” med åtta HBM3-kapslar om 24 GB med en bandbredd om dryga 660 GB/s för en total kapacitet om 192 GB respektive 5,3 TB/s. För dörren ligger en ny generation HBM3E-lösningar från Samsung, Micron och SK Hynix, samtliga med 36 GB per kapsel och bandbredd om 1,28 TB/s vardera.

Efter HBM3E kommer HBM4 som ställer betydligt högre krav på paketeringstekniker för att uppnå än högre bandbredd och göra det energieffektivt. För att möta detta har både SK Hynix och Samsung ingått samarbete med TSMC för att få HBM4, en ny generation CoWoS och avancerade beräkningskretsar på 3 nanometer att giftas samman till framtidens AI-lösningar.