Nästa generations High-Bandwidth Memory (HBM), HBM4, är möjliggörare för nästa generations högpresterande AI-kretsar och i slutet av 2025 inledde såväl SK Hynix som Samsung sina leveranser till Nvidia. Då Nvidia med tidigare generationers HBM3 och HBM3E ratat Samsung ses detta som en seger för den sydkoreanska elektronikjätten, men den inhemska rivalen SK Hynix spås fortsatt bli AI-jättens klart största leverantör även med HBM4.

Källor till den sydkoreanska nyhetsbyrån Yonhap gör gällande att SK Hynix ska stå för hela två tredjedelar, eller närmare 70 procent, av allt HBM4 avsett för Nvidias nästa generations AI-beräkningskretsar kodnamn ”Rubin”. Allokeringen uppges vara långt över tidigare prognoser, som räknade med att SK Hynix ”enbart” skulle möta drygt 50 procent av Nvidias totala HBM4-efterfrågan.

Att Nvidia väljer att öka framtida leveranser från SK Hynix, istället för dess konkurrenter Samsung och Micron, förklaras av analytiker med ett – förtroende. Då SK Hynix var tidigt ute att satsa på och utveckla High-Bandwidth Memory fick de ett försprång både räknat i volym och kompetens, något rivalerna behövt arbeta ikapp de senaste åren. Samsung kämpade under lång tid med att få sina HBM3E-kretsar kvalificerade av Nvidia, som ratade dessa då SK Hynix lösningar krasst presterade bättre.

Samsung å sin sida avser att öka sin andel av HBM4-kretsar hos Nvidia med hjälp av en tvådelad offensiv. Bolagets nyckelkomponenter är dess tekniska avancemang och vertikal integration, som vare sig SK Hynix eller Micron har till förfogande. Tillverkningstekniskt tillverkar Samsung HBM4 på sjätte generationens 10-nanometersprocess (1c), medan SK Hynix och Micron fortsatt nyttjar generation fem (1b). Förutsatt att Samsung tillverkar dessa med bra yield betyder detta framförallt att deras minneslösningar blir mer energieffektiva.

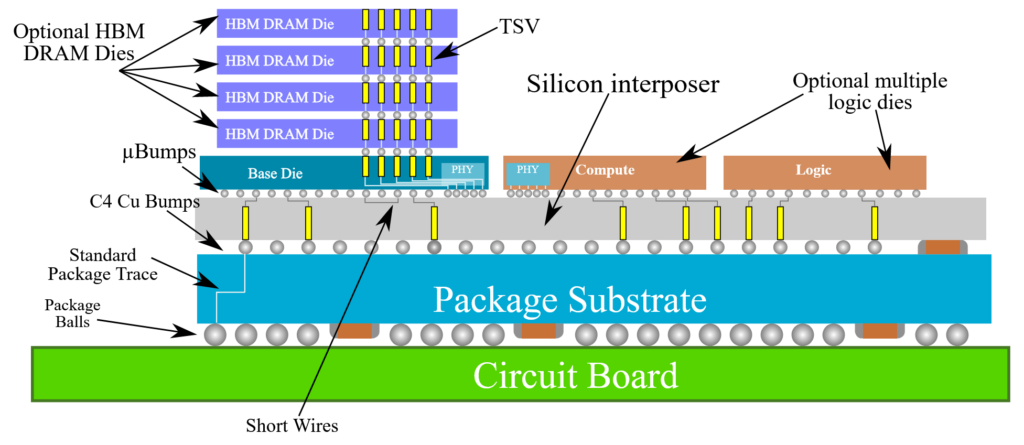

Med HBM4 ställs högre krav på signalintegritet för att få bättre prestanda och energieffektivitet. Lösningen på detta är en bättre logikkrets eller substrat, base die, som upp till 12 DRAM-kretsar staplas på. Hittills är det någonting den samlade minnestrion Samsung, SK Hynix och Micron kunnat leverera på egen hand, men då de två senare saknar djupare kompetens och kapacitet för tillverkning av logikkretsar tar de med HBM4 hjälp av TSMC.

Samsung å sin sida är världsunik i produktionen av minnes- och logikkretsar, vilket möjliggör för den vertikal konkurrenterna inte förmår. Förutom att kontrollera hela kedjan och ha möjlighet att finkornigt anpassa sina kretsar levereras deras HBM4 med en tillverkningstekniskt mer avancerad base die tillverkad på 4 nanometer – att jämföra med TSMC:s 12 nanometer. Värt att nämna är att även TSMC arbetar på 5-nanometersproduktion för ändamålet, men det är något som väntas komma först senare.

Huruvida Samsungs på pappret tillverkningstekniska fördelar kan omsättas till en marknadsmässig fördel återstår att se. Likt Samsungs foundry-division har minnesdivisionen på senare år präglats av problem, med konsekvens att elektronikjätten inledningsvis missade det AI-tåg som avgick när ChatGPT lanserades för allmänheten november 2022. Målsättningen lär oavsett vara att återta ledarpositionen på minnesmarknaden – en sits position bolaget tappat till SK Hynix efter att inte ha lyckats med storskalig HBM-produktion.