Nvidia kan komma att bli en leverantör av hela servrar för rackmontering med start 2026 års AI-plattform med kodnamnet Vera Rubin, rapporterar Wccftech med hänvisning till servertillverkaren Wistrons kvartalsrapport. Det skulle potentiellt innebära att Nvidia kan minska ledtiderna för nya kretsar att nå ut på marknaden, då slutkunder inte behöver vänta på att AI-acceleratorer först levereras till partnertillverkare – samtidigt som Nvidia kan tänkas räkna hem högre marginaler.

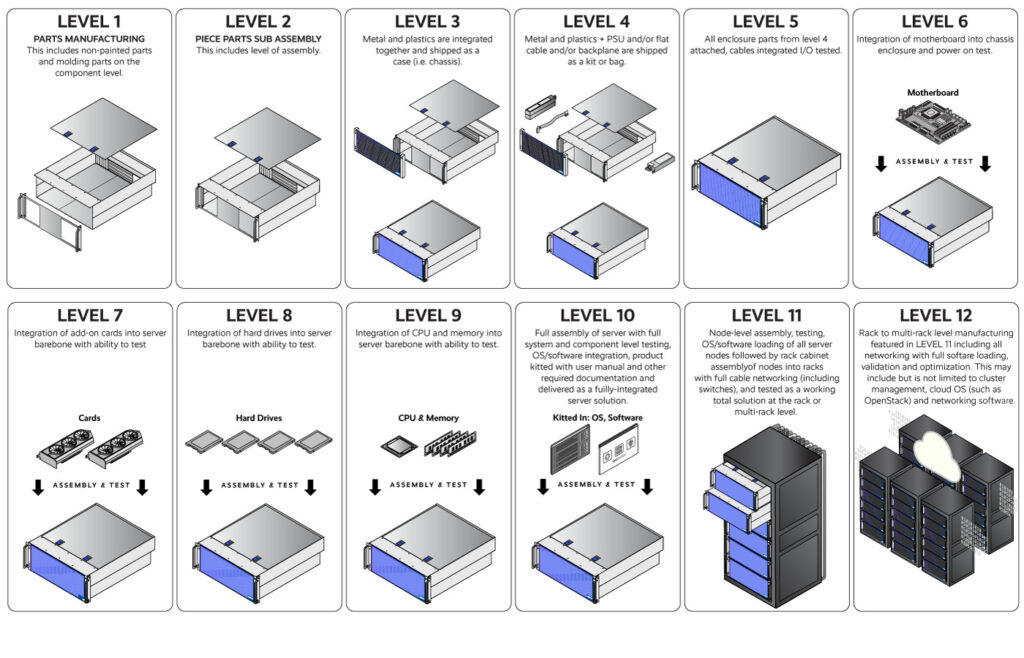

Enligt rapporterna har ODM-bolaget (Original Design Manufacturer) Wistron inte uttryckt någon oro, då bolaget istället för att agera systemintegratör åt traditionella serverbolag likt Dell, HPE och Supermicro uppges fortsätta med samma uppdrag direkt åt Nvidia. Vad Nvidia uppges ha ute på upphandling är kompletta Level 10-system, vilket i en serverhall motsvarar en helt färdigbyggd låda med hårdvara, monterad kylning och anslutningar – redo att monteras i ett rack och strömsättas.

I praktiken innebär det en liknande resa Nvidia redan tidigare har gjort på konsumentsidan, där bolaget under mitten av 2010-talet började sälja grafikkort i egen regi efter att sedan grundandet ha förlitat sig på partnertillverkare. Då väckte tilltaget från Nvidia visst tandagnissel hos historiskt trogna partner, som redan hade tunna marginaler och hård konkurrens sinsemellan. Att Nvidia nu ser ut att göra detsamma inom serverhårdvara innebär däremot att de ekonomiska insatserna är betydligt högre.

Nvidias partnertillverkare marknadsför idag hela rack med 72 av dagens vassaste AI-acceleratorer, GB200 NVL72, där 36 Grace-CPU:er paras med 72 Blackwell-baserade AI-acceleratorer. Kostnaden för kalaset uppges vara ungefär 3 miljoner USD – medan sagda systemintegratörer i dagsläget åtminstone får välja sina leverantörer av minne, lagring, nätaggregat och kylning och anpassa sina egna chassin.

Allt detta hoppas Nvidia nu ändra på, genom att leverera hela Level 10-lösningar. Kvar för partner enligt Tom’s Hardware blir endast att välja chassi och nätaggregat för att sedan montera en komplett compute tray från Nvidia, följt av funktionstest. Bland fördelarna nämns att systemintegratörer inte längre behöver designa hårdvara själva och lägre kostnader till följd av skalfördelar då Nvidia med sin köpkraft upphandlar minne, lagring, kylning och komponenter likt kablar i massiv skala.

Resultatet väntas i själva verket sannolikt bli bättre marginaler för Nvidia, på bekostnad av ett mindre varierat utbud av serverhårdvara. Huruvida det gör någon skillnad för bolagen som ska driva servrarna lär framtiden får utvisa, men åtminstone servertillverkarna lär jubla. Mer information lär tillkännages i samband med Nvidias kommande kvartalsrapport, onsdag den 19 november.