Under våren införde USA hårdare exportrestriktioner av avancerade AI-beräkningskort till Kina, vilket i praktiken satte stopp för Nvidias och AMD:s försäljning till landet. Störst inverkan fick det för Nvidia, som till följd av kostnader direkt kopplade till det Kina-anpassade beräkningskortet H20 fick göra avskrivningar om 5,5 miljarder USD.

Trots att Nvidia blev bränt av de åtstramade restriktionerna är de inte redo att ge upp Kina, som bolaget trots högteknologiskt handelskrig ser som viktig för dess tillväxt. Hittills har de Kina-anpassade doningarna baserats på arkitekturerna Ampere och Hopper, och antagandet har varit att den senare åter skulle ligga till grund för ett ännu mer avskalat beräkningskort.

Att det skulle röra sig om Hopper är dock uppgifter som Nvidias egen VD Jen-Hsun Huang avfärdat i taiwanesisk TV med orden ”Det är inte Hopper, eftersom det inte är möjligt att modifiera Hopper längre”. Att det inte är möjligt är inte helt sant, däremot är det möjligt att det inte vore ekonomiskt försvarbart att skala ned och sälja en i grunden dyr plattform ännu billigare.

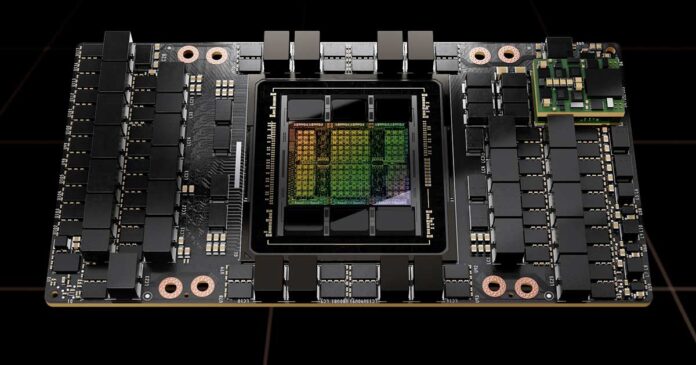

Som kort bakgrund blev AI-beräkningskortet H100 tillgängligt oktober 2022, men redan då gick det inte att exportera till Kina på grund av handelsrestriktioner. Nvidias svar på detta blev ett H800, där de strypt hastigheten och möjligheterna att koppla samman hur många kort som helst via gränssnittet NVLink. När även H800 ansågs för kraftfullt tillkom H20 med betydligt större ingrepp, som mindre minnesmängd med lägre bandbredd och färre CUDA-kärnor – en produkt som i grunden är ett H100/H200, som säljs till ett kraftigt ”rabatterat” pris i Kina.

Istället för att fortsätta skala ned regelrätta AI-beräkningskort ytterligare kan nästa ha anor från konsumentmarknaden. Detta enligt Nikkei Asia, som rapporterar att nästkommande lösning får grafikminne av den konsumentorienterade typen GDDR7 istället för HBM3, vilket kommer märkas i form av betydligt lägre bandbredd och sämre energieffektivitet.

Valet av arkitektur är ännu inte klarlagt, men utifrån minnestypen är det mest troligt att det blir en grafikkrets (GPU) baserad på senaste Blackwell – som paradoxalt nog är mer effektiv än Hopper. En konsumentorienterad grafikkrets innebär dock per automatik flera kompromisser där den största är total avsaknad av gränssnittet NVLink, vilket krävs för att kunna sammankoppla flera GPU:er. Det här skulle kraftigt begränsa möjligheterna att effektiv köra storspråksmodeller (LLM) och inferens, och göra det ointressant för stora delar av AI-marknaden.

Ett separat spår som är mindre troligt, men inte omöjligt, är att Nvidia lägger resurser på att utveckla en GPU särskilt för den kinesiska marknaden. Det vill säga en helt ny bit kisel och inte något befintligt där de inaktiverar funktioner för att möta USA-regeringens lågt satta prestandakrav. Då skulle de kunna ta Hopper och dess viktiga funktioner som NVLink och bygga in en helt ny minneskontroller med GDDR7-stöd. Med andra ord en balanserad lösning som lever upp till den amerikanska regeringens prestandatak räknat i bland annat flyttalsoperationer per sekund (FLOPS) och bandbredd.

En bastardlösning likt ovan låter sig dock inte göras i en handvändning. Kostnaderna i forskning och utveckling skulle landa i häraden flera hundra miljoner USD, och tiden för att utveckla en sådan tingest är av tidigare branscherfarenhet som bäst 18 månader. Vad som faktiskt händer får tiden utvisa, men klart är att Nvidia inte vill ge upp den kinesiska marknaden. Den större frågan är dock om inte Kina kommer vilja ge upp på Nvidia i takt med att Huawei bygger allt bättre produkter som kan konkurrera mot Nvidias bakbundna dito.