Det explosionsartade intresset och användningsområden för artificiell intelligens (AI) har fått hårdvara för ändamålet att skjuta i höjd. Att efterfrågan skulle gå upp i den takt den gjort och fortfarande gör var det ingen i industrin som förutsåg, och nu arbetar alla delar i leveranskedjan febrilt för att möta marknaden.

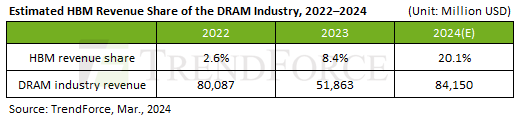

För att mata beräkningskretsarna med data används minnestekniken High-Bandwidth Memory (HBM), som fram till relativt nyligen var en nischprodukt. Enligt analysfirman Trendforce svarade HBM under 2022 för 2,6 procent av marknaden för primärminne (DRAM), där förutom HBM även DDR och GDDR ingår. Denna andel tredubblades till 8,4 procent 2023 och under innevarande år väntas omsättningen för HBM svara för cirka 20 procent av marknaden.

Det som gör HBM eftertraktat är att det kan leverera flerfalt högre bandbredd än GDDR, som traditionellt använts för grafikkort tillika beräkningskretsar för AI. Medan det med dagens GDDR6(X) är möjligt att nå en bandbredd runt en terabyte per sekund (TB/s) levererar aktörer likt Nvidia och AMD med dagens HBM3-skodda AI-kretsar med HBM3 runt 5 TB/s. Tekniken är även överlägsen gällande energieffektivitet, men nackdelen är att priset per gigabit (Gb) är betydligt högre än för GDDR – varför den aldrig blev någon framgång för grafikkort i konsumentklassen som i regel har lägre marginaler.

Inom DRAM är det Samsung, SK Hynix och Micron som utgör den så kallade ”minneskartellen” och således även är de som har förmåga att tillverka HBM i skala. Av trion var det SK Hynix som innan AI-boomen investerade stort i forskning, utveckling och kapacitet, vilket också gett bolaget ett försprång med en marknadsandel om cirka 80 procent. Samsung och Micron som tidigare varit mindre ambitiösa har nu växlat upp sina HBM-ambitioner.

Att HBM är en bristvara beror dels på tidigare blygsamma investeringar i tekniken, vilket nu åtgärdas med expansion av befintliga och byggnation av nya fabriker. En annan faktor som påverkar är att HBM tar längre tid att tillverka än traditionellt DRAM, som dagens GDDR6 och DDR5, med en produktionscykel som är 1,5–2 månader längre. Relaterat är att HBM använder Through-Silicon Via (TSV) för att stapla upp till 12 minneskretsar i samma kapsel för att ge större kapacitet.

Tekniken TSV är dock en komplicerad process som drar ned yield, där HBM jämfört med DDR uppges ligga 20–30 procent lägre. Den siffran tillskrivs sannolikt marknadsledaren SK Hynix som haft tid att förfina tekniken. Tidigare uppgifter talar nämligen om att bolaget har en yield för HBM om 60–70 procent medan Samsung, som på allvar började satsa på HBM3 långt efter sina landsmän, ligger på blott 10–20 procent. Detta är någonting Samsung uppges försöka åtgärda genom att använda samma paketeringsteknik som SK Hynix för stapling, istället för att envetet fortsätta gå sin egen väg.

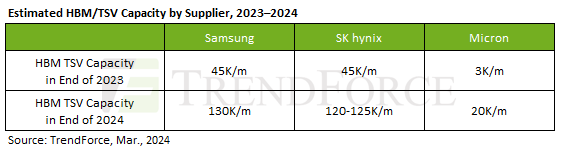

Under 2023 hade SK Hynix och Samsung liknande tillverkningskapacitet för HBM, men den senare med betydligt lägre marknadsandel vilket stärker bilden av låg yield. Duons kapacitet låg under 2023 på runt 45 000 kiselskivor (eng. wafer) per månad, vilket överskuggar amerikanska Microns 3 000 kiselskivor. När trion skalar upp 2024 handlar det om närmare en tredubbling för sydkoreanerna medan Micron relativt sett skruvar upp rejält till 20 000.

Att HBM säljer som smör i solsken betonades nyligen av Microns VD, Sanjay Mehrotra, som under bolagets senaste kvartalsrapport angav att deras orderböcker är fyllda för hela 2024 och en bra bit in på 2025. År 2025 är perioden då stora delar av industrin, då inte minst TSMC, angett att bristen på AI-beräkningskort är till ända.