Marknaden för AI-beräkningskretsar är minst sagt glödhet och framförallt Nvidia täljer guld på den trend som i slutet av 2022 sattes igång med ChatGPT. Att Nvidia idag är marknadsledande ska tillskrivas att de under många år satsat stort på att bygga upp ett ekosystem, med hårdvara och mjukvara, för artificiell intelligens (AI). Bolagets framgångar har nu även spillt över på dess underleverantörer och då inte minst minnestillverkarna.

Nu rapporterar analysfirman Trendforce att minnesmarknaden för DRAM står inför ett stort skifte, där minnestypen High-Bandwidth Memory (HBM) som används för AI-kretsar i toppskiktet växer i rasande takt. Detta väntas ske på bekostnad av traditionellt primärminne inom kategorin DRAM, vilket inkluderar bland annat DDR-typer för datorer av olika slag och andra interaktiva produkter samt GDDR-varianter för framförallt grafikkort.

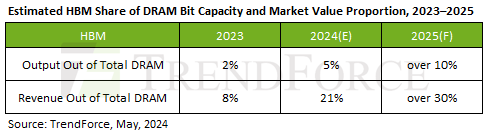

Under 2023 när AI-hypen på allvar tog fart svarade HBM för blott 2 procent av DRAM-marknaden räknat i levererad datakapacitet (bit) och 8 procent av intäkterna, detta är siffror som under innevarande år väntas stiga betydligt till 5 respektive 21 procent. För 2025 spår Trendforce att HBM kommer stå för mer än 10 procent av leveranserna och 30 procent av intäkterna.

HBM är i dagsläget är runt fem gånger dyrare än traditionellt DRAM, vilket gör det mer lukrativt än att producera DDR5 som har betydligt mindre marginaler. Att HBM är dyrare beror dels på att den skyhöga efterfrågan på AI-kretsar gjort det till en bristvara, en direkt konsekvens av att minnestillverkarna blev tagna på sängen över hur explosionsartat efterfrågan växt, men även att det är betydligt svårare att producera. För att nå hög kapacitet på liten yta och energieffektivitet förlitar sig HBM på vertikal stapling (3D) av kretsar, vilket är svårare att tillverka än traditionellt DRAM där staplingen är begränsad till exklusivt DDR5-minne förekommande i datacenter.

Att minnestillverkarna SK Hynix, Micron och Samsung skruvar upp investeringarna av HBM gör att tillgängligheten på DDR5 per automatik sjunker och blir dyrare. Medan en prisuppgång var väntad tros den ske snabbare än väntat, så till den grad att Trendforce behövt justera upp sina prognoser rejält. Analysfirman spådde först att priserna för serverorienterat DRAM-minne under andra kvartalet 2024 skulle stiga med 3–8 procent, men räknar nu med en betydligt högre uppgång om 15–20 procent. Dessa siffror gäller implicit idag dominerande DDR5, men då andra DDR-, LPDDR- och GDDR-varianter tillverkas i samma fabriker bör det gälla även dessa tekniker.

Siffrorna från Trendforce visar att marknaden i dagsläget är svår att förutspå och hur den utvecklas beror inte enbart på minnestillverkarnas förmåga att skala upp HBM-produktionen. Världens största kontraktstillverkare av kretsar, TSMC, ska under 2023 års avslutande kvartal ha nått 100 procent beläggning på sina noder i 5-nanometersklassen, där beräkningskretsar för AI-bruk ska ha varit direkt bidragande till att fylla fabrikernas maskiner till brädden. Samtidigt kämpar TSMC med att växla upp produktionen av paketeringstekniken Chip-on-Wafer-on-Substrate (CoWoS), vilket är det lim som gifter samman AI-kretsarna med HBM-minnet.

Det är med andra ord tre komponenter – HBM, AI-kretsarna och CoWoS – vars symbios avgör pris och tillgång på marknaden. Oavsett vilket syns inga tecken på att efterfrågan på AI-kretsar är på väg att minska och minnestillverkarna jublar säkerligen över att de efter en ekonomisk vinter har en högmarginalprodukt med HBM, som samtidigt ser till att skruva upp priserna på traditionellt DRAM.